This post is also available in:

English (אנגלית)

English (אנגלית)

מחקר חדש גילה כי מודלי שפה מציגים נטיות תרבותיות מובהקות, התלויות בשפה שבה הם מייצרים תוכן. חוקרים מ-MIT ואוניברסיטת טונגג'י חקרו כיצד המודלים הללו מתנהגים באנגלית ובסינית, במטרה להעריך את ההטיות התרבותיות האפשריות שטמונות בטקסטים שנוצרים על ידי בינה מלאכותית.

ככל ששימוש בבינה מלאכותית צובר פופולאריות, כך גדלות השאלות בנוגע לאובייקטיביות ולדיוק שלה. המחקר, שהתפרסם ב-Nature Human Behavior, הוא אחד הראשונים העוסקים כיצד הם עשויים לשדר ערכים תרבותיים שונים בהקשרים לשוניים שונים.

על פי TechXplore, החוקרים התמקדו בשני היבטים תרבותיים: אוריינטציה חברתית וסגנון קוגניטיבי. אוריינטציה חברתית מתייחסת להאם אנשים מדגישים עצמאות או תלות הדדית, בעוד שסגנון קוגניטיבי מתאר אם אנשים מעבדים מידע בצורה הוליסטית או אנליטית. מחקרים קודמים מצביעים על כך שתרבויות מערביות נוטות לעדיף אינדיבידואליזם וחשיבה אנליטית, בעוד שתרבויות מהמזרח, כגון סין, נוטות להדגיש תלות הדדית וחשיבה הוליסטית.

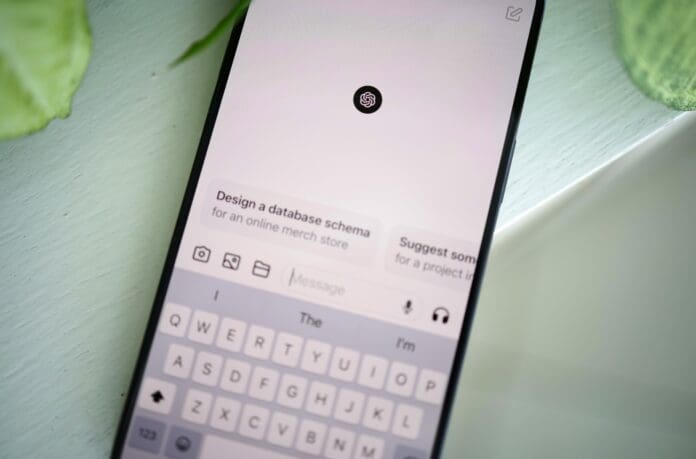

החוקרים התמקדו בשני מודלים: ChatGPT, הפופולרי במערב, ו-Ernie, הפופולרי בסין. המחקר מצא שכאשר השתמשו ב-GPT ו-ERNIE בסינית, התשובות שלהם שיקפו נטיות יותר תלויות הדדית והוליסטיות בהשוואה לתשובותיהם באנגלית. ChatGPT במיוחד, הציג תוכן יותר שיתופי וממוקד קהילה בעת יצירת טקסט בסינית, בעוד שבאנגלית הוא סיפק תשובות עצמאיות ואינדיבידואליסטיות יותר. באופן דומה, ERNIE, הציג דפוסים תרבותיים דומים.

באופן מעניין, המחקר מציע כי ניתן להפוך את מודלי הבינה המלאכותית לניטרליים יותר מבחינה תרבותית או להתאימם לערכים מסוימים באמצעות "הנחות תרבותיות" – בקשה מהמודל לאמץ את נקודת מבטו של אדם מתוך תרבות מסוימת. גישה זו מאפשרת לבצע התאמות בתוכן שנוצר בהתבסס על ההקשר התרבותי הרצוי על ידי המשתמש.

ממצאי המחקר פותחים דלת למחקר עתידי בנוגע להטיות תרבותיות במודלים של בינה מלאכותית ומציעים דרך לפיתוח טכנולוגיות רגישות יותר או ניתנות להתאמה תרבותית.