This post is also available in:

English (אנגלית)

English (אנגלית)

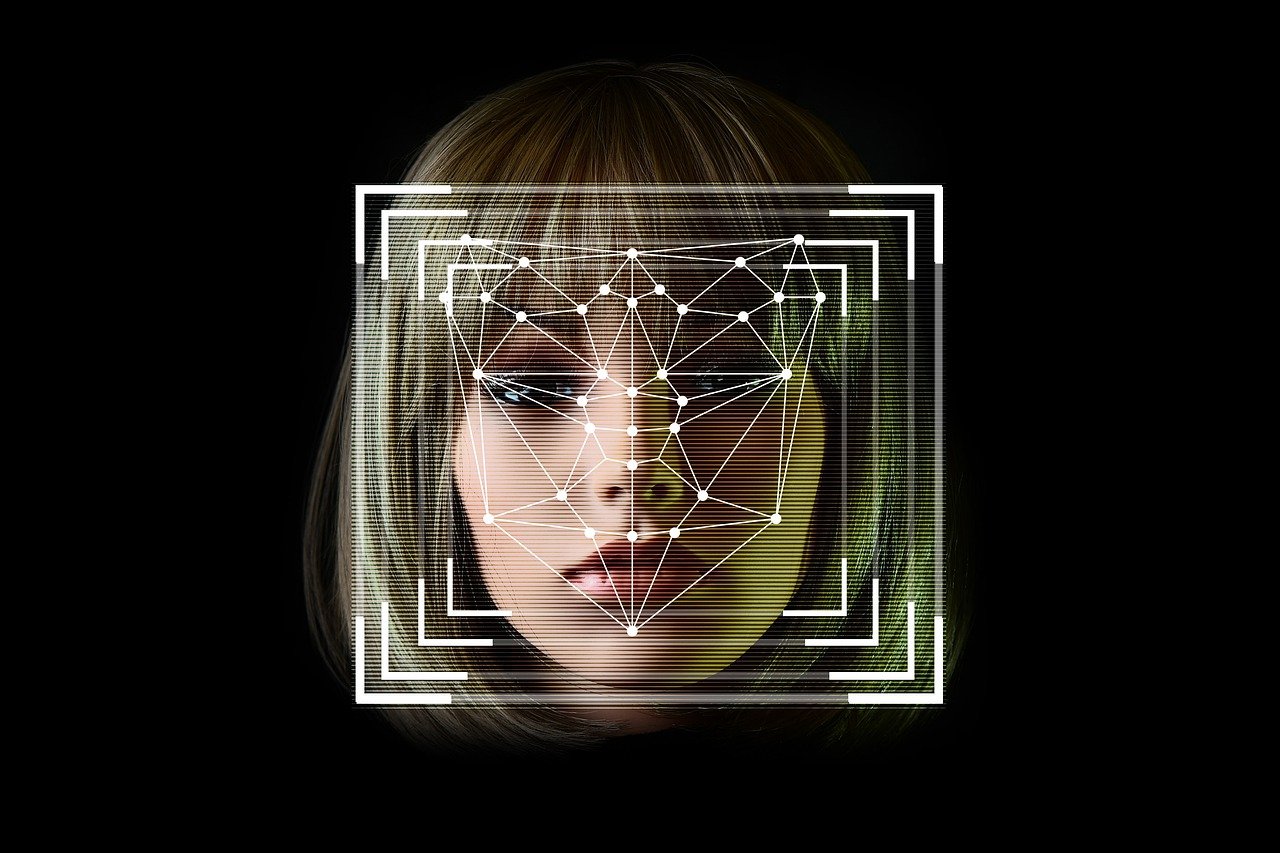

טכנולוגיית ה-Deepfake, ייצור תמונות או קטעי וידאו או אודיו שנראים אותנטיים לחלוטין ויכולים לבלבל אפילו צופים ומאזינים מומחים, צוברת פופולריות וחדשנות בקצב מהיר. היא הביאה איתה בעיות רבות והוכיחה את יכולתה להשפיע על היבטים חשובים בחיינו, כמו עולם הפוליטיקה.

עידן חדש זה של הונאה טכנולוגית מביא איתו תמונות וקטעי וידאו מזויפים שמגיעים אפילו לכותרות ולחדשות, ולמרות שלרוב מצהירים עליהם כזיופים די במהירות, לפעמים הנזק כבר נעשה, במיוחד בעידן של הוויראליות באינטרנט.

לפי Techxplore, מניפולציות דיגיטליות שיכולות לשנות או ליצור מחדש פרצופים אנושיים תורמות לבעיית ה"פייק ניוז" ומרעילות את אמון הציבור במדיה הדיגיטלית. מחקר שפורסם לאחרונה ב-"International Journal of Autonomous and Adaptive Communications Systems" מתאר גישה חדשה שיכולה לזהות אם המדיה היא דיפ-פייק על ידי איתור חוסר עקביות בתאורה בתוך תמונות.

החוקרים מאוניברסיטת מדע המידע והטכנולוגיה בסין מסבירים כי ניתן לסווג דיפ-פייקים לארבעה סוגים עיקריים, כאשר כל אחד מהם מהווה איום שונה: חילופי זהויות, חילופי הבעות פנים, מניפולציות ייחוס וסינתזת פנים שלמה.

הם מדגישים כי הסוגים המסוכנים ביותר הם "חילופי זהות" (בהם "מלבישים" פנים של אדם על פניו של אחר) ו-"חילופי הבעות פנים" (בהן מעבירים הבעות פנים מאדם לאדם), ומוסיפים כי דיפ-פייקים באופן כללי עלולים לגרום נזק חמור למוניטין ולתפיסה של האדם אותו "מזייפים".

כשמדובר בזיהוי הטכנולוגיה, הגישה הרגילה היא "סיווג בינארי", אבל היא נוטה להיכשל אם הווידאו או התמונות דחוסים מאוד או נמצאים באיכות ירודה שמעוותת ומערפלת את הפנים ומפחיתה את הסיכוי לזיהוי. לעומת זאת, אפילו מומחים בתחום הדיפ-פייק יכולים להתקשות בלהתאים את התאורה בצורה מושלמת למדיה המקורית אותה הם מחקים – בעיה בה החוקרים התמקדו בשיטת הזיהוי שלהם המשתמשת ברשת עצבית כדי לזהות סתירות תאורה.