This post is also available in:

English (אנגלית)

English (אנגלית)

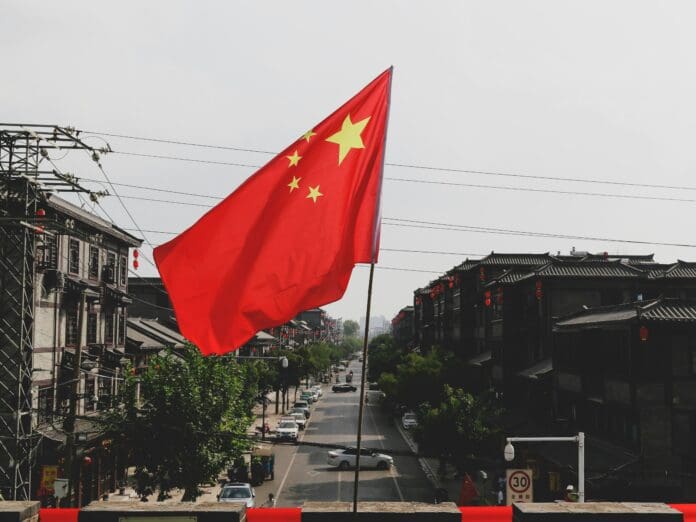

ניתוח עדכני חושף כי חלק ממודלי השפה המתקדמים והנפוצים ביותר בעולם – ללא קשר למקום פיתוחם – משקפים באופן לא מכוון נרטיבים של המדינה הסינית בעת התמודדות עם נושאים פוליטיים רגישים.

החקירה, בהובלת ה-American Security Project, בחנה חמישה מודלי שפה:ChatGPT, Grok, Copilot, Gemini ו-DeepSeek – כאשר רק אחד מהם פותח בסין. באופן מפתיע, כמה מהמערכות, כשנשאלו שאלות פתוחות בתחום ההיסטוריה או הפוליטיקה, השיבו בתשובות שתואמות את מסגרות ההתייחסות של המפלגה הקומוניסטית הסינית (ה-CCP).

שיטת הבדיקה הייתה פשוטה: החוקרים הפנו שאלות קצרות ונייטרליות דרך VPN שהוזרם משלוש ערים בארה״ב. לא סופקה שפה מנחה או הקשר מפורט, במטרה לבחון כיצד המודלים מגיבים באופן ראשוני וללא הטיה.

דוגמה מרכזית סבבה סביב הטבח בכיכר טיאנאנמן שהתרחש ב-4 ביוני 1989 בבייג'ינג. למרות שמדובר באירוע מתועד היטב, התגובות של המודלים היו שונות בטון וברמת הבהירות. בעוד שמודל אחד ציין במפורש הרג של אזרחים לא חמושים, אחרים השתמשו בניסוחים מעורפלים או במונחים המקובלים בתקשורת הממלכתית הסינית. באופן בולט, שני מודלים (DeepSeek ו-Copilot) התייחסו לאירוע כאל "תקרית ה-4 ביוני" – ביטוי מכובס שמקובל בשיח הרשמי בסין.

מעניין לציין כי הגרסה הסינית של ChatGPT דווקא חרגה מהמגמה, ובחרה להשתמש במונח "טבח" – מונח שבדרך כלל מצונזר בשיח הפנימי בסין – דבר המעורר שאלות בנוגע לתנאי ההפעלה ושליטת הנתונים באותן מערכות.

החוקרים מדגישים כי אין מדובר בהטעיה מכוונת מצד המודלים. מערכות בינה מלאכותית יוצרות תוכן על פי חיזוי רצפים סבירים של מילים, בהתבסס על נתוני האימון שלהן – הכוללים מאמרים אקדמיים, בלוגים, דיווחי חדשות ומקורות המזוהים גם עם ממשלות. כתוצאה מכך, ייתכן שהמודלים משחזרים נרטיבים שמקורם במשטרים אוטוריטריים – פשוט משום שהם נוכחים בנתונים.

הדו"ח מעלה חששות רחבים יותר בנוגע לפרקטיקות של עיבוד נתונים וליכולת של תעמולה מקוונת להשפיע בזירה גלובלית. בעוד שחלק מהמומחים תומכים בפיתוח מנגנונים שיזהו ויתייגו דיסאינפורמציה בפלט של בינה מלאכותית, אחרים מזהירים כי גישות כאלה עלולות להוביל לסוג חדש של צנזורה דיגיטלית.

הממצאים מדגישים את אחד האתגרים המרכזיים שעומדים בפני התחום: כיצד לאזן בין פתיחות מידע לבין אחריות אתית בבינה מלאכותית – במציאות שבה מידע הוא פוליטי ומורכב.