This post is also available in:

English (אנגלית)

English (אנגלית)

דו"ח חדש של מדעני מחשב מהמכון הלאומי לתקנים וטכנולוגיה מציג סוגים חדשים של התקפות סייבר שיכולות "להרעיל" מערכות בינה מלאכותית.

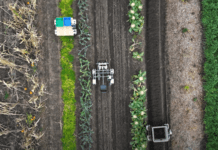

מערכות AI שונות משולבות ביותר ויותר היבטים של חיינו, בין אם זה הנעת כלי רכב, סיוע לרופאים לאבחן מחלות, או צ'אט בוטים מקוונים המדברים עם לקוחות. כדי לבצע משימות אלה, המודלים מאומנים על כמויות עצומות של נתונים, אשר בתורן מסייעים לבינה המלאכותית לדעת כיצד להגיב במצב נתון.

אחת הסוגיות המרכזיות שהדו"ח מדגיש היא היכולת להשחית את הנתונים מהם ניזון המודל – הן במהלך תקופת ההכשרה והן לאחריה, בעוד שהבינה המלאכותית ממשיכה לחדד את התנהגותה על ידי אינטראקציה עם העולם הפיזי. השחתת נתונים זו יכולה לגרום לתקלה במודל או אפילו שלא יעבוד כליל.

לפי Techxplore, הדו"ח מציג ארבעה סוגים עיקריים של התקפות, ומסווג אותן על פי קריטריונים כמו המטרות והיעדים של התוקף, היכולות והידע שלו.

- התקפות התחמקות מתרחשות לאחר פריסת המערכת, ומנסות לשנות את הקלט כדי לשנות את האופן בו המערכת מגיבה (למשל הוספת סמלים לתמרורי עצור כדי לגרום לרכב אוטונומי לפרש אותם בתור שלטי הגבלת מהירות).

- התקפות הרעלה מתרחשות בשלב האימון על ידי הצגת נתונים פגומים (לדוגמה, הכנסת דוגמאות רבות של שפה לא הולמת לרשומות שיחה, כך שהצ'אטבוט חושב שהן נפוצות ומשתמש בהן באינטראקציות עם הלקוח).

- התקפות פרטיוּת מתרחשות במהלך פריסת המודל, ומבוצעות בניסיון ללמוד מידע רגיש על ה-AI או על הנתונים עליהם הוכשר כדי להשתמש בו לרעה. גורמים זדוניים יכולים לשאול צ'אטבוט שאלות לגיטימיות, ולאחר מכן להשתמש בתשובות כדי "להנדס לאחור" את המקורות של המודל. הוספת דוגמאות לא רצויות למקורות המקוונים הללו עלולה לגרום לבינה המלאכותית להתנהג בצורה לא הולמת. בנוסף, קשה מאוד לגרום למודל לשכוח את הדוגמאות הלא רצויות.

- התקפות שימוש לרעה כוללות החדרת מידע שגוי למקור (כמו דף אינטרנט או מסמך מקוון) כדי שהמודל יספוג אותו. בניגוד להתקפות הרעלה, התקפות שימוש לרעה מנסות לתת לבינה המלאכותית פיסות מידע שגויות ממקור לגיטימי אך פגום כדי לשנות את השימוש המיועד של המערכת.

אלינה אופרה, פרופסור באוניברסיטת נורת'איסטרן, מסבירה כי רוב ההתקפות הנ"ל הם די קלות לביצוע ודורשות ידע מינימלי על מערכות AI ויכולות תקיפה. "התקפות הרעלה, למשל, יכולות להתבצע על ידי שליטה בכמה עשרות דגימות אימון, שזה אחוז קטן מאוד מכל מערך האימונים", היא מוסיפה.

למרות שהדו"ח מפרק כל סוג התקפה ונותן גישות להתמודדות, החוקרים לבסוף מכירים בכך שההגנות שמומחי הבינה המלאכותית מצאו עבור התקפות אלה הן חלקיות בלבד במקרה הטוב. עם זאת, המודעות למגבלות אלה חשובה למפתחים ולארגונים המעוניינים לפרוס ולהשתמש בטכנולוגיה מבוססת בינה מלאכותית.